Wenn Ingenieure irren, oder: Der steinige Weg zu zuverlässigen Produkten

Die zuverlässige Auslegung von Bauteilen ist bereits fast 4000 Jahre alt. Dennoch kommt es immer wieder zu tragischen Unglücken. In diesem Artikel wollen wir eine kurze Übersicht über die Historie der sicheren Bauteilauslegung geben und ein paar Beispiele aufzeigen, worin die Schwierigkeiten für die Ingeieur:in liegen, die Bauteile sicher zu gestalten.

In diesem Artikel lernen Sie,

- wie wichtig die Zuverlässigkeit von Bauteilen bereits vor 4000 Jahren war

- welche typischen Ursachen großen Katastrophen zugeordnet werden können,

- welche Schlussfolgerungen daraus für Sie als Ingenieur:in gezogen werden.

Inhalt

- Historie

- Beispiele von Ausfällen

- Wenn die Kosten wichtiger sind als die Qualität: Einsturz der Brücke Firth of Tay

- Die Geburt der Betriebsfestigkeit: Zugentgleisung von Amstetten

- Wenn Wissen zur zuverlässigen Auslegung in der Wissenschaft noch nicht vorhanden ist: Der Einsturz der Quebec Brücke

- Never change a running System: das Zugunglück von Eschede

- Die Schwierigkeit der Lastannahme: Reaktorunglück Fukushima

- Zusammenfassung

- Schlussfolgerungen

1 Historie

Bereits im Codex Hammurapi, der Rechtssammlung des König Hammurapis von Babylon (* 1810 v. Chr.; † 1750 v. Chr.) sind Hinweise für zuverlässige Bauwerke vorhanden. In den Paragraphen 229 bis 233 wird die Haftung des Baumeisters für fehlerhafte Bauten festgehalten. Danach galt das Prinzip Auge um Auge, …. Baut ein Baumeister ein Haus das einstürzt, da es nicht fest genug gebaut wurde und der Hauseigentümer, dessen Sohn oder Sklaven dabei ums Leben kommt, so wird der Baumeister oder dessen Sohn ebenfalls getötet, bzw. der Baumeister muss einen gleichwertigen Sklaven übergeben. Auch der Materielle Schaden muss ersetzt werden.

Die Gestaltung zuverlässiger Produkte ist somit schon seit Jahrtausenden eine Herausforderung. In der Antike musste man sich hierfür überwiegend auf Erfahrungen stützen. Heutzutage bemüht man die Wissenschaft, um die Grenzen der Werkstoffe auszunutzen und diese zuverlässig auszulegen. So beschrieb bereits Leonardo da Vince etwa die Zugfestigkeit von Eisendrähten oder die Biegefestigkeit von Balken.

Mit der Zeit wurde das Wissen größer, die Methoden zur Auslegung genauer, die Bauteile robuster und sicherer. Gleichzeitig stieg aber auch die Komplexität der Produkte dramatisch an. Dies führte dazu, dass leider immer auch Wissenslücken bleiben, die zum Teil zu sehr tragischen Unglücken führen, wenn technische Mängel auftreten.

In diesem Artikel sollen ein paar dieser tragischen Unglücke inklusive deren technischer Ursache dargestellt werden. Ziel ist es, den IngenieurInnen, die in den Bereichen der Zuverlässigkeitstechnik arbeiten, die Möglichkeit zu geben, von diesen Fehlern zu lernen. Denn je mehr wir Fehler analysieren, diese verstehen, daraus lernen, umso besser werden unsere Methoden und umso robuster die Produkte zukünftig.

2 Beispiele von Ausfällen

2.1 Wenn die Kosten wichtiger sind als die Qualität: Einsturz der Brücke Firth of Tay

2.1.1 Katastrophe

Die Firth-of-Tay-Brücke ist eine 3 km lange schottische Eisenbahnbrücke. Die erste Brücke wurde zwischen 1871 und 1878 erbaut und stürzte am 28.12.1879 während eines Orkans teilweise ein, als der Schnellzug von Edinburgh nach Dundee fuhr. Dabei starben 75 Personen.

Bei der Brücke wurde in Bezug auf die Spannweite und die Dimension technisches Neuland betreten. Es war die damals längste Brücke der Welt.

Die eingestürzte Firth-of-Tay-Brücke

2.1.2 Ursache

Bei der Auslegung gegenüber Windlasten wurden diese zu gering angenommen. Es wurden nur Windlasten von 50 kg / Quadratmeter angenommen, im Gegensatz zu den bisher bekannten Windlasten aus Frankreich von 270 kg / Quadratmeter. Diese höheren Lasten nachträglich zu berücksichtigen hätten das Projekt verteuert, was wiederum die Aktionäre und Eigentümer der Eisenbahngesellschaft ablehnten. Zusätzlich wurden die Fahrgeschwindigkeiten der Züge mit 60 km/h angenommen (der maximalen Zuggeschwindigkeit zum Zeitpunkt der Planung). Allerdings lagen diese 10 Jahre später zum Zeitpunkt der Inbetriebnahme bereits bei 110 km/h, was zu deutlich höheren Brückenlasten führt. Die offizielle Geschwindigkeitsbegrenzung wurde teilweise ignoriert.

Zusätzlich wiesen die verwendeten Gussbauteile z. T. Qualitätsmängel in Form von Lunkern auf. Dies war zur damaligen Zeit nicht unüblich. Jedoch hätten die mangelhaften Teile wieder eingeschmolzen werden müssen. Allerdings geschah dies nicht, sondern die fehlerhaften Stellen wurden mit einem Harz-/Metallstaubgemisch gefüllt oder nachträglich ausgegossen. Durch diese Maßnahmen sank die Festigkeit z.T. auf 33%. Daneben wurden weitere grundlegende konstruktive Fehler begangen. Das waren z.B. falsch angezogene Schrauben, nicht angebrachte Unterlagscheiben, ….

Bereits zu Beginn wurden die Baukosten als zu hoch eingeschätzt. Deshalb wurden die Brückenpfeiler entgegen der ursprünglichen Planung nur im unteren Teil gemauert, und in Oberenteil als Eisenkonstruktion über Stützen ausgeführt. Die Ursprüngliche Planung sah mehrere Stützen vor, die untereinander über Winkeleisen miteinander versteift werden sollten. Zu Kostensenkung wurde dann jedoch nur Bandmaterial verwendet.

Währen der Bauarbeiten zeigte sich, dass der Untergrund das geplante Gewicht nicht tragen konnte. Um die Last der Brücke dennoch abtragen zu können, wurde die Grundfläche der Pfeiler vergrößert, wodurch sich die Pfeiler verteuerten. Deshalb wurde ihre Anzahl verringert und die Tragweite von 61 Meter auf 76 Meter verlängert.

Bereits in den ersten Wochen des Betriebs der Brücke berichteten Zeugen, dass sich Eisenteile von der Brücke lösten und ins Wasser fielen. Diese Zeugenaussagen wurden jedoch nicht weiter verfolgt.

2.1.3 Schlussfolgerung

In diesem Fall führten ein sehr hoher Kosten- und Zeitdruck, deutlich zu geringe Lastannahmen, nicht ernst genommene Qualitätsmängel und auch technische Schlamperei sowie das Ignorieren der ersten Warnzeichen zu dieser Tragödie.

Als Schlussfolgerung daraus wurden bei künftigen Brückenprojekten die Windlasten und die daraus resultierenden Kippmomente genauer berücksichtigt.

2.2 Die Geburt der Betriebsfestigkeit: Zugentgleisung von Amstetten

2.2.1 Katastrophe

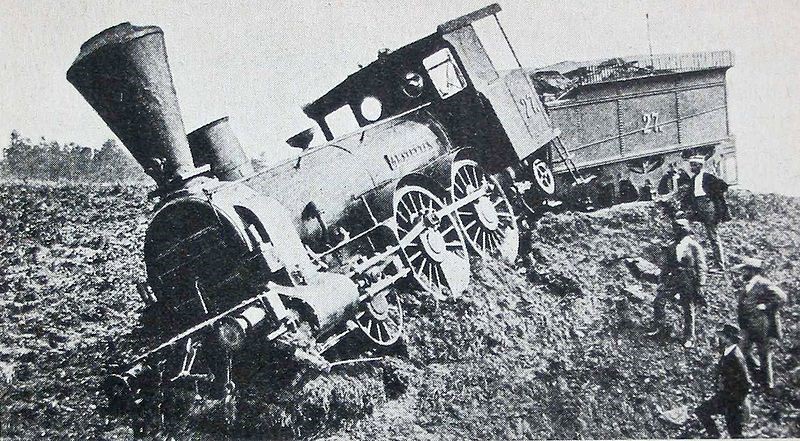

Am 19.10.1875 entgleiste die Lokomotive Amstetten nähe Timelkam auf Grund des Bruchs eines Radreifens. Dabei kam es zu keinerlei Personenschäden (Quelle).

Zugunglück der Lokomotive Amstetten nähe Timelkam

2.2.2 Ursache

Dieser Unfall steht stellvertretend für ein Problem der damaligen Zeit, in der mehrere Brüche an Eisenbahnachsen auftraten, obwohl diese sehr gut nach dem damaligen Stand der Technik ausgelegt waren.

Ursächlich für diesen Ausfall war kein Materialfehler, sondern das bis dahin nicht bekannte Phänomen der Werkstoffermüdung. D.h. es wurde ein bis dahin unbekannter Schadensmechanismus angeregt.

Bereits 1852 wurde Hr. August Wöhler als Mitglied der "Kommission für Untersuchung von Lokomotiven respektive Ermittlung der besten Konstruktionsverhältnisse derselben" eingesetzt. Ziel dieser Kommission war es, die Ursachen für die Achsbrüche zu finden und Konstruktionsmaßnahmen vorzuschlagen. Ab 1856 betraute Hr. Wöhler die Dauerversuche und Messungen an Bahnachsen zur Untersuchung deren Festigkeit an der Berliner Bauakademie.

Als Ergebnis dieser Untersuchungen beantragte er 1874 die „Einführung einer staatlich anerkannten Klassifikation für Eisen und Stahl". Ziel dieser Klassifikation war die Festlegung für die Dauerfestigkeit von Eisen und Stahl in Abhängigkeit der Werkstoffeigenschaften wie der Zugfestigkeit und der Bruchdehnung.

Grundursache für den Unfall von Timelkam war die Umstellung der Stahlproduktion auf neue Verfahren, wodurch dieser härter aber auch gleichzeitig spröder wurde. Leider wurden durch die höhere Sprödigkeit die Eisenbahnachsen auch anfälliger für zyklische Belastungen. Als Ergebnis dieser Untersuchung wurde für die künftige Auslegung von Eisenbahnachsen eine neue Kennzahl für geeignete Stähle in Abhängigkeit der Zähigkeit und der Festigkeit des Stahls vorgeschlagen (L. von Tetmajer, „Zur Frage der Classification von Eisen und Stahl,“ Die Eisenbahn = Le chemin de fer, pp. 92-94, 16 14/15 1881. )

2.2.3 Schlussfolgerung

Immer wenn bei Bauteilen ein bisher unbekannter Schadensmechanismus angeregt wird, führt dies zu hohen Ausfällen. Denn: auf diesen Schadensmechanismus (in diesem Fall das Versagen durch Dauerbruch) kann nicht ausgelegt werden.

Erst eine genaue Analyse des Versagens und eine Erweiterung der vorhandenen Auslegungsmethoden liefert dann eine Möglichkeit Bauteile zuverlässig auszulegen.

2.3 Wenn Wissen zur zuverlässigen Auslegung in der Wissenschaft noch nicht vorhanden ist: der Einsturz der Quebec Brücke

2.3.1 Katastrophe

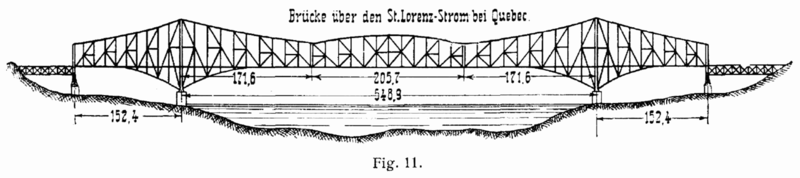

Am 29.08.1907 stürzte die noch im Bau befindliche Québec-Brücke mit einer damals einzigartigen Spannweite von 521 m über den Sankt-Lorenz-Strom zwischen den Städten Québec und Lévis in der Provinz Québec in Kanada erstmals ein. Dabei kamen 75 Arbeiter ums Leben.

Ein zweiter Einsturz erfolgte am 11. September 1916, wobei 13 Menschen ihr Leben verloren.

Entwurf der Quebec Brücke

2.3.2 Ursache

Bei der Konstruktion der Brücke wurde die Belastung durch das Eigengewicht angenommen. Das Eigengewicht konnte jedoch nur angenommen und nicht exakt berechnet werden. Deshalb wurde das reale Gewicht während der Bauarbeiten ermittelt und es sollten dann je nach Bedarf notwendige Verbesserungen vorgenommen werden. Während der Bauarbeiten wurde abgeschätzt, dass das erhöhte Eigengewicht nur zu einer geschätzten Erhöhung der Spannungen um sieben bis zehn Prozent führt. Deshalb wurde davon ausgegangen, dass diese Spannungserhöhung im Rahmen der Toleranzen liegen und keine Änderungen notwendig sind. Tatsächlich war das Eigengewicht aber um 25% höher als angenommen.

Die Bauarbeiten verliefen ohne größere Probleme. Erst als das Eigengewicht in die Größe der Traglast kam, gab es Probleme beim Nieten. Die Teile passten nicht exakt zusammen. Außerdem wurden ungewöhnliche Verformungen an Teilen der Konstruktion festgestellt. Tragischerweise wurden die großen Verformungen aber einem Unfall bei der Montage und einer Vorverformung bereits vor der Montage zugeschrieben. Ein Baustopp erfolgte nicht.

Als das gesamte Ausmaß der Situation bewusst wurde, traf der angeordnete Baustopp leider zu spät auf der Baustelle ein.

2.3.3 Schlussfolgerung

Ungenaue Lastannahmen bezüglich des Eigengewichtes (und die unterlassene Überprüfung dieser Annahme während des Baus) haben zu einer zu hohen Beanspruchung der Brückenkomponenten geführt.

Außerdem war zum damaligen Zeitpunkt das Wissen über das Knickverhalten druckbeanspruchter Stahlbauteile noch unzureichend vorhanden. Damit hat das damals zur Verfügung gestandene Wissen nicht ausgereicht, um Brücken mit druckbeanspruchten Stahlträgern in dieser Dimension (Stützweite) wirtschaftlich zu planen und zu bauen.

Auch die Warnzeichen der sich verformten Bauteile wurden falsch interpretiert.

2.4 Never change a running System: das Zugunglück von Eschede

2.4.1 Katastrophe

In 1998 kam es zum Entgleisen eines ICE in Eschede. Es war die größte Zugkatastrophe in der Geschichte der Bundesrepublik Deutschland. Dabei kamen 101 Menschen ums Leben, 88 wurden schwer verletzt, siehe folgende Abbildung.

Zugunglück von Eschede

2.4.2 Ursache

Die Ursache lag in der Umstellung von Vollrädern auf gummigefederte Einringräder. Die Umstellung erfolgte, da es durch Materialermüdung und Abnutzung der Vollräder zu Resonanzerscheinungen kommen konnte, was in Kundenbeschwerden sowie Risiken für Strecke und Zug resultierte. Bei der Auslegung der neuen Einringräder war man mangels geeigneter Prüfstände auf eine rechnerische Auslegung angewiesen. Ähnliche Räder wurden bei Straßenbahnen eingesetzt. Dort wurden deutlich vor Erreichen der rechnerischen Verschleißzeit Reifenbrüche festgestellt, was zu verkürzten Inspektionsintervallen führte. Eine Warnung ging an alle Nutzer ähnlicher Räder, wurde aber auf Grund der unterschiedlichen Bauart als nicht relevant eingestuft. Bei der Wartung am Vortag des Unfalls wurden unzulässig hohe Rundlauf- und Höhenabweichungen des Radsatzes festgestellt, dokumentiert, jedoch entgegen den Instandsetzungsrichtlinien nicht als sicherheitskritisch eingestuft.

2.4.3 Schlussfolgerung

Ein großes Risiko sind Änderungen. Dies schließt auch die Übernahmen von bisher bekannten Technologien (in diesem Fall den Radreifen) in unbekannte Einsatzbereiche ein. Hier sind bei der Auslegung und Absicherung immer größte Vorsicht geboten.

Oftmals kündigen sich Probleme frühzeitig an (wie in diesem Fall durch die erhöhten Abweichungen des Radsatzes bei der Inspektion). Werden diese ignoriert, können daraus hohe Konsequenzen erwachsen.

2.5 Die Schwierigkeit der Lastannahme: Reaktorunglück Fukushima

2.5.1 Katastrophe

Am 11. März 2011 kam es auf Grund des durch das Töhoku Erdbeben ausgelösten Tsunami zu einer Kernschmelze in mehreren Reaktorblöcken des japanischen Kernkraftwerks Fukushima Daiichi.

Auf Grund des Erdbebens wurden alle im Betrieb befindlichen Reaktoren abgeschaltet. Außerdem brach durch das Erdbeben auch die externe Stromversorgung ein. Deshalb wurden die Kraftwerkseigenen Notstromaggregate zur Stromversorgung aktiviert.

Durch den Tsunami wurden mehrere Reaktorblöcke und die Notstromaggregate überschwemmt, da die 13…15 m hohen Tsunamiwellen die 5,7 m hohen Schutzmauern um bis zu 5 m überspülten. Auf Grund der Überschwemmung fiel auch ein Großteil der Notstromaggregate und damit die Stromversorgung aus. Der Ausfall der Stromversorgung führte dann zu einer nicht mehr ausreichenden Kühlung eines Teils der Reaktoren, in welchen es daraufhin zu einer Kernschmelze kam.

In Folge des Unfalls mussten etwa 100 000 Einwohner evakuiert werden, da die Japanische Atomaufsichtsbehörde die Ereignisse als mit der Höchststufe 7 als katastrophalen Unfall einstufte. Geschätzt kamen 730-1260 Menschen dabei ums Leben (Quelle).

Reaktorunglück von Fukuschima

2.5.2 Ursache

Das Kraftwerk wurde in den 1960er Jahren errichtet. Zum damaligen Zeitpunkt nahm man an, dass der Standort als relativ sicher gegenüber Erdbeben ist. Daraufhin wurden entsprechende nach dem damaligen Stand der Technik abgesicherte Tsunami Schutzmaßnahmen umgesetzt.

Auf Grund der sich deutlich verbesserten Tsunami-Forschung kam die Wissenschaft und auch der Betreiber des Kernkraftwerks 2010 zu dem Schluss, dass man mit deutlich höheren Tsunamiwellen rechnen muss. Leider wurden die offiziellen Vorgaben nicht geändert. Rückblickend kamen mehrere Experten zu dem Schluss, dass Erdbeben dieser Größenordnung an dieser Stelle nach dem damaligen Stand nicht vorhersehbar waren.

Neben den technischen Ursachen, wurde auch das Krisenmanagement bewertet. Die japanische Regierung beurteilt ihre eigene Organisation bezüglich der Fähigkeit, auf einen solchen nuklearen Notfall angemessen zu reagieren, als unzureichend. Insbesondere, da Aufgaben und Verantwortungen unklar verteilt waren. Gleiches gilt für die Zusammenarbeit zwischen den staatlichen Behörden und dem Betreiber TEPCO. Wahrscheinlich hätten einige der Probleme durch ein besseres Krisenmanagement vermieden werden können.

Zusätzlich wurde die Verfügbarkeit der Experten und Mitarbeiter für den Krisenstab ebenfalls als ungenügend angesehen.

2.5.3 Schlussfolgerung

Leider sind in diesem Fall die wissenschaftlichen Erkenntnisse über die mögliche Höhe eines Erdbebens nicht rechtzeitig verfügbar gewesen, um das Kraftwerk sicherer auslegen zu können. Dies führte dazu, dass die angenommenen Lasten in Form von Tsunamiwellen nicht ausreichend berücksichtigt wurden.

Neben den technischen Problemen waren tragischerweise auch menschliche Fehler auszumachen. So war etwa das Krisenmanagement ungenügend, um auf einen solchen Vorfall angemessen reagieren zu können.

3 Zusammenfassung

Rekapituliert man die Schlussfolgerungen aus oben genannten Beispielen, dann können die Ursachen für die Katastrophen grob in folgende drei Kategorien eingeteilt werden:

3.1 Unzureichendes Wissen

Bei der Gestaltung eines Produktes muss unbedingt die zum Versagen führende Physik bekannt und verstanden sein. Am Beispiel der Zugentgleisung von Amstetten etwa war der Schadensmechanismus durch das Versagen durch Dauerbruch unbekannt. Beim Beispiel der Quebec-Brücke konnte man etwa Stäbe auf Knicken noch nicht richtig auslegen. Und bei dem Fukushima Unglück wusste man noch nicht, dass die Tsunami doch deutlich höher sein können, als bisher angenommen.

Fehlt das Wissen über einen Schadensmechanismus, dann liegen natürlich auch keine Auslegungsrichtlinien vor. Dadurch kann das Bauteil auch nicht gegen dieses Risiko abgesichert werden.

3.2 Unsicherheit bei der Lastannahme

Für eine zuverlässige Bauteilauslegung müssen immer die auf das Produkt wirkenden Lasten berücksichtigt werden. Leider sind diese Lasten oftmals unbekannt und müssen angenommen werden. Siehe dazu die Beispiele des Fukushima Unglücks oder dem Einsturz der Quebec-Brücke.

Lastannahmen stellen wahrscheinlich die größte Unsicherheit bei einer Zuverlässigkeitsgestaltung dar. Diese können nicht oft genug hinterfragt werden.

3.3 Menschliche Faktoren

Neben den Technischen Risiken spielt auch der Mensch eine nicht zu unterschätzende Rolle. Die Ursache liegt z.B. daran, dass neben der Beherrschung der technischen Risiken auch immer ein gewisser Zeit- und Kostendruck vorherrscht. Dies wurde beim Beispiel der Brücke Firth of Tay sehr deutlich, wo ein großes Augenmerk auf die Erreichung der Kostenziele zu Lasten der technischen Lösungen gelegt wurde.

Ein Weiteres Problem stellt immer wieder die Übernahme bekannter Lösungen in bisher neue Umgebungen dar, wenn die Auswirkung der neuen Umgebungen nicht richtig bewertet wird. So führte beispielsweise die Übernahme der gummigefederten Einringräder aus dem Straßenbahnbau in den Bau der Hochgeschwindigkeitszüge zu Problemen.

Oftmals kündigen sich Probleme bereits frühzeitig etwa bei Erprobungen, der frühen Nutzungsphase oder in ähnlichen Produkten an. Werden diese nicht direkt als Probleme erkannt und als „Ausreisser“ deklariert, ist die Katastrophe programmiert. So etwa geschehen bei der Erkennung der verformten Bauteile der Quebec-Brücke oder die erhöhten Abweichungen des Radsatzes bei der Inspektion der ICE Radsätze bzw. das Lösen von Eisenteilen der Firth of Tay Brücke. Vorsicht deshalb unbedingt vor der Vorschnellen Festlegung von Auffälligkeiten als Ausreisser!

4 Schlussfolgerungen

Leider werden sich Fehler nie vollständig vermeiden lassen. Eine Minimierung ist jedoch sehr gut möglich. Das zeigen die nächsten drei Beispiele. Aufgabe eines Zuverlässigkeitsingenieurs ist es, diese so gut wie möglich umzusetzen.

4.1 Warum alles schief gehen muss: Murphys Law

Edward A. Murphy war ein Ingenieur der US Air Force. 1947 war er an einem Raketenexperiment beteiligt, bei dem die Beschleunigungen auf eine Testperson gemessen werden sollten. Dazu wurden am Körper der Testperson 16 Beschleunigungssensoren angebracht. Diese konnten entweder richtig, oder um 90° verdreht montiert werden. Am Ende des Tests zeigte sich, dass alle Sensoren falsch montiert wurden und damit das Ergebnis wertlos war.

Diese Erfahrung brachte Hr. Murphy zu seiner Aussage: „Wenn es mehrere Möglichkeiten gibt, eine Aufgabe zu erledigen, und eine davon in einer Katastrophe endet oder sonstwie unerwünschte Konsequenzen nach sich zieht, dann wird es jemand genau so machen.“ Quelle.

In der Amerikanischen Zeitschrift „Flight Safety Bulletin“ veröffentlichte man 1955 ein auf Murphy’s Aussage beruhendes humoristisches Gesetz für Luftfahrtingenieure:

- Ein fallengelassenes Werkzeug fällt dorthin, wo es den größten Schaden anrichten kann

- Ein beliebiges Rohr ist nach dem Kürzen immer zu kurz

- Nach dem Auseinander- und Zusammenbauen einer Vorrichtung bleiben immer einige Teile übrig.

- Die Anzahl der vorhandenen Ersatzteile ist reziprok proportional zu ihrem Bedarf.

- Wenn irgendein Teil einer Maschine falsch eingebaut werden kann, so wird sich jemand finden, der das auch tut.

- Alle hermetischen Verbindungen sind undicht.

- Bei einer beliebigen Berechnung wird die Zahl, deren Richtigkeit für alle offensichtlich ist, zur Fehlerquelle.

- Die Notwendigkeit, an Konstruktionen prinzipielle Änderungen vorzunehmen, steigt stetig in dem Maße, je näher der Abschluss des Projektes bevorsteht.

Mit diesem „Gesetz“ wollte man darauf aufmerksam machen, dass bei der Entwicklung technischer Systeme alle potenziellen Fehler, egal wie wahrscheinlich diese sind, bei der Auslegung berücksichtigt werden müssen.

4.2 Wie wir Fehler vermeiden können: Poka Yoke

Im Japanischen kennt man aus diesen Gründen etwa das Prinzip Poka Yoke („unglückliche Fehler Vermeiden“). Dieses Prinzip beruht auf dem Grundgedanken, dass kein System und kein Mensch fähig sind, fehlerfrei zu Arbeiten. Ziel ist es deshalb, das Auftreten von Fehlern unmöglich zu machen, indem etwa die Montage zweier Teile nur auf eine Art möglich ist. Poka Yoke ist ein wichtiges Element des Toyota Produktionssystems.

Beispiele dafür sind etwa CEE Stecker, die sich je nach Spannung und Frequenz sowohl in Farbe, als auch Form unterscheiden, so dass ein falsches Montieren unmöglich ist.

4.3 Wie wir die Sicherheit deutlich steigern können: Redundanzen

Können Fehler nicht vermieden werden, muss deren Eintrittswahrscheinlichkeit so gering wie möglich gehalten werden. Dazu werden gerne Redundanzen eingebaut. Das bedeutet, dass beim Ausfall einer Komponente eines Systems eine weitere Komponente vorhanden ist, so dass der Systemausfall vermieden wird. Beispiele dafür sind vielfältig, etwa das Vorhandensein eines Reservefallschirms beim Fallschirmsprung, oder dass drei Prozessoren im Flugzeug dieselben Rechnungen ausführen.

Wie wichtig diese Redundanzen sind, zeig ein Zwischenfall eines B52 Bombers im Jahre 1961. Damals stürzte ein B52 Bombers der zwei Atombomben an Bord hatte über North Carolina in den USA ab. Dabei lösten sich die beiden Atombomben und fielen zur Erde. Eine dieser Bomben wäre möglicherweise beinahe explodiert, da drei der vier redundanten Sicherheitsvorrichtungen ausgefallen waren. Nur die letzte Sicherheitsvorrichtung war noch intakt. Dies zeigt, wie wichtig redundante Systeme sind.

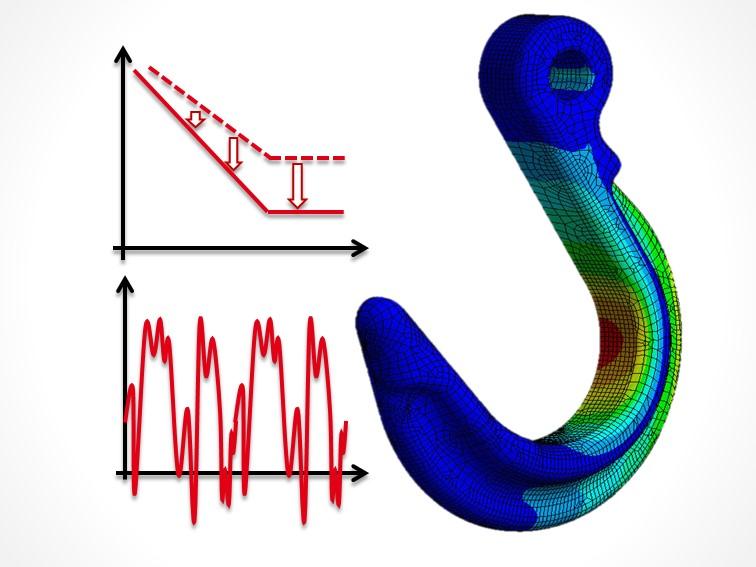

4.4 Wie die Sicherheit von Bauteilen berechnet werden kann: Die Betriebsfestigkeit oder die Zuverlässigkeit

Können Fehler nicht vermieden werden, muss deren Eintrittswahrscheinlichkeit so gering wie möglich gehalten werden. Das bedeutet, dass Bauteile so ausgelegt werden müssen, dass ein Fehler sehr gering ist.

Möglich ist eine solche Auslegung mit Hilfe der Methoden der Betriebsfestigkeit oder der technischen Zuverlässigkeit.

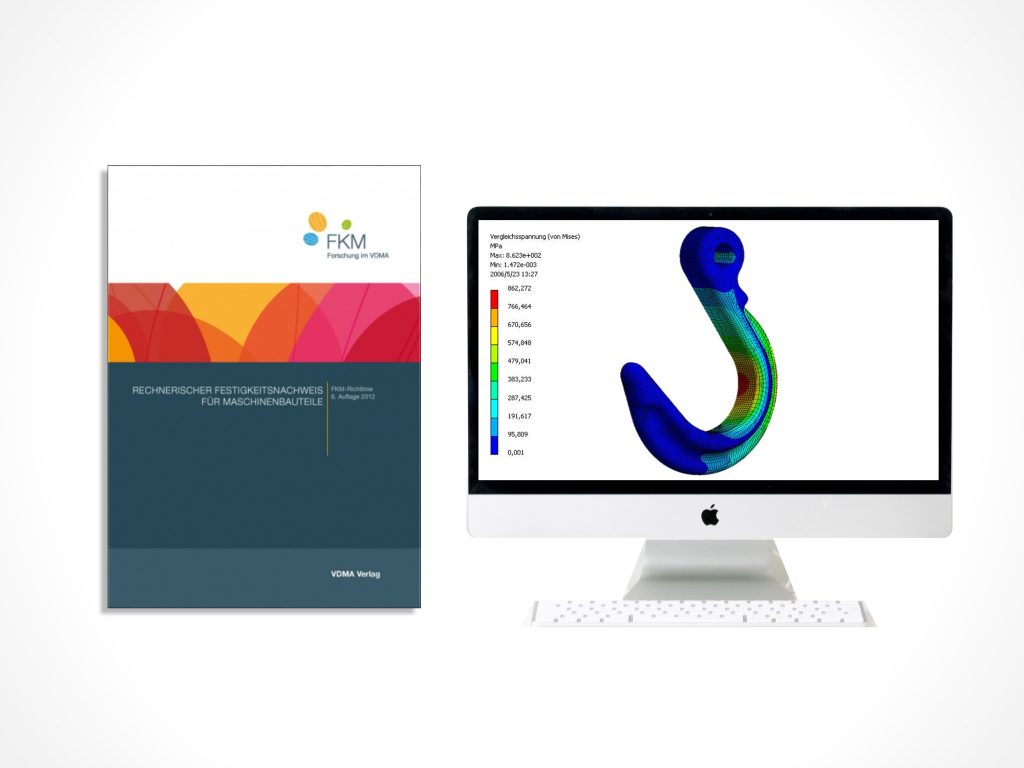

Hierfür existieren zahlreiche Normen, welche das Wissen dazu bündeln und für den Berechnungsingenieur direkt anwendbar dokumentieren. Ein Beispiel dazu ist die FKM Richtlinie.

Weiterführende Informationen zur FKM Richtlinie und Wöhlerkurven

Hier finden Sie ähnliche Artikel und Informationen zu passenden Seminaren. Außerdem können Sie den Inhalt des Artikels bewerten.

Bewerte den Artikel!

[yasr_visitor_votes size="medium"]

Seminar Betriebsfestigkeit mit FEM

Das Seminar zur Betriebsfestigkeit gibt Ihnen einen guten Überblick über die Methoden der Betriebsfestigkeit und der FEM. Hier lernen Sie

✓alle wichtigen Methoden kennen, um Ihre Bauteile robust auf die Betriebsfestigkeit auszulegen.

✓Schweißverbindungen auszulegen.

✓verstehen, welche Faktoren die Lebensdauer Ihrer Bauteile besonders stark beeinflussen.

✓Grundlagen der Finite-Elemente-Ergebnisse (FEM) kennen, anzuwenden und zu interpretieren.

✓Lastkollektive mit Hilfe der Rainflowzählung zu ermitteln.

✓eine Wöhlerlinie für Ihre Bauteile rechnerisch abzuschätzen.

✓Bauteillebensdauern mittels Schadensakkumulation zu berechnen.

✓Dauerschwingfestigkeitsnachweise zu führen.

✓die modernen Regelwerke wie die FKM Richtlinie zur Betriebsfestigkeitsbewertung kennen.

Seminare zur FKM Richtlinie:

Haben Sie Interesse an einer schnellen Anwendung und einem einfachen Einstieg in die komplexe FKM Richtlinie? Dann ist unsere Schulung zur FKM Richtlinie für Sie richtig.

Diese ist genau richtig für Sie, wenn Sie

✓ die FKM Richtlinie schnell anwenden möchten.

✓ Ihre FEM Ergebnisse bewerten wollen.

✓ die Hintergründe der FKM Richtlinie verstehen und üben wollen.

Weiterführende Literatur

Um Bauteile betriebsfest oder dauerfest auszulegen und um die Hintergründe der FKM Richtlinie zu verstehen, bietet sich außerdem unser

Um Bauteile betriebsfest oder dauerfest auszulegen und um die Hintergründe der FKM Richtlinie zu verstehen, bietet sich außerdem unser

Buch Betriebsfestigkeit und FEM an.

dieses führt Sie schnell und verständlich in die Versuche und die Betriebsfestigkeit ein und liefert gleichzeitig noch viele Excel Tools zur einfacheren Auslegung Ihrer Bauteile auf die Dauerfestigketi oder Betriebsfestigkeit. Sie können dann einfach Wöhlerlinien für Ihre Bauteile berechnen.

Hilfreiche Software:

Wir haben basierend auf unserer jahrelangen Erfahrung, der Mitarbeit in den Forschungsgremien zur FKM Richtlinie und dem praktischen Arbeiten mit der Richtlinie FKMmadeEASY- die Excel-Software zur FKM Richtlinie entwickelt. Wir haben dabei speziell darauf geachtet, dass diese Software

✓ einfachst möglich bedienbar

✓ gut dokumentiert und nachvollziehbar sowie

✓ optisch ansprechend ist (es soll ja auch Spaß machen).

Überzeugen Sie sich selbst davon anhand der Testversion von FKMmadeEASY - die Excel-Software zur FKM Richtlinie

Der Autor:

Bildernachweis

Photo by janilson furtado on Unsplash