Fake News selber erstellen! Oder: Wie wir unsere Daten sicher statistisch auswerten.

Die Betriebsfestigkeit und auch die technische Zuverlässigkeit sind empirische Fachgebiete. D.h. die Methoden dieser Fachgebiete wurden durch Experimente oder Beobachtungen ermittelt. Dazu sind Versuche notwendig, welche mit Hilfe der Statistik ausgewertet werden müssen. In diesem Artikel zeigen wir, wie man die Statistik richtig anwendet, um vernünftige Ergebnisse zu erzielen.

In diesem Artikel lernen Sie:

- Worauf es bei einer Darstellung und Präsentation statistischer Ergebnisse ankommt (sowohl beim Vortragenden, als auch beim Publikum).

- Wie Sie Daten präsentieren und zusammenfassen um Ihr Publikum schnell abzuholen.

- Wie Sie statistische Tricks schnell erkennen.

- Wie Sie den Eindruck der Datenmanipulation vermeiden.

Inhalt

- Motivation

- Die richtige Einstellung

- Daten präsentieren

- Mit Statistik tricksen - Fake News erstellen

- Auf den Punkt

- Weiterführende Infos

1 Motivation

Daten können immer unterschiedlich präsentiert werden, z. B. abhängig von der Person oder dem Interesse desjenigen, der präsentiert. Dazu ein kleines Beispiel zur Illustration.

Der sicherste „Beruf“ der Welt ist „Präsident der Vereinigten Staaten von Amerika“. In den 225 Jahren, die es diesen Beruf gibt, sind nur vier Berufstätige durch einen „Arbeitsunfall" ums Leben gekommen. Der durchschnittliche Abstand zwischen zwei tödlichen Unfällen liegt bei 56 Jahren.

Der gefährlichste „Beruf“ der Welt ist „Präsident der Vereinigten Staaten von Amerika“. Von 43 Berufstätigen kamen fast 10% - also jeder zehnte - durch einen "Arbeitsunfall" ums Leben. Diese Quote erreichen noch nicht einmal Fischer, Bergleute oder Soldaten.

Ist die Absicht hinter der Dateninterpretation positiv, dann spricht man von einer fachmännischen Interpretation. Ist die Intention dagegen negativ, spricht man von Manipulation. Um im Ingenieursalltag zu fachmännischen Interpretationen zu kommen, ist es wichtig, die statistischen Methoden richtig anzuwenden. Dazu liefert Ihnen dieses Kapitel anhand vieler Beispiele das wichtigste Wissen.

2 Die richtige Einstellung

Wir neigen dazu unsere Ideen bestätigen zu wollen. Dafür suchen wir Lob und Anerkennung von Kollegen und Vorgesetzten. Wir hassen es uns kritischen Fragen zu stellen. In der Wissenschaft wird dies Verteidigung der Ergebnisse genannt. Wer eine wissenschaftliche Arbeit geschrieben hat, der kennt dieses Verfahren. Dabei geht es darum die eigenen Erkenntnisse so darzustellen, dass diese auch Kritikern standhalten.

In der beruflichen Praxis sieht das etwas anders aus. Hier geht es darum, sich von einem geeigneten (möglichst breiten) Kollegenkreis ein Feedback abzuholen. Hier sollen bewusst positive Aspekte genauso hervorgehoben werden wie Verbesserungsmöglichkeiten.

Warum ist das so wichtig? Es gibt eine Vielzahl an potenziellen Risiken die in der industriellen Praxis abgefangen werden müssen um zuverlässige Produkte auf den Markt zu bringen. Es ist nicht möglich diese Risiken komplett alleine zu finden und zu bearbeiten. Für eine möglichst effektive Bearbeitung bietet es sich an, die Rückmeldung möglichst vieler Kollegen unterschiedlicher Kompetenzen durch ein Feedback einzusammeln. Anschließend kann das Feedback in die eigene Arbeit eingearbeitet werden und die eigene Arbeit gewinnt dadurch an Qualität. Dafür braucht es zwei Dinge:

- Der Vortragende muss eine offene Einstellung haben und Feedback ehrlich wollen. Aufgabe des Vortragenden ist es, diese Einstellung mitzubringen und das Publikum ggfs. darauf hinzuweisen, wenn eine kritische Stimmung entsteht.

Als Vortragende wollen wir von den Rückmeldungen lernen und das Produkt verbessern.

- Insbesondere das Management muss beim Feedbackgeben die richtige Einstellung haben und konstruktiv Rückmeldungen geben. Das schließt das Positive (Lob) und das Kritische (Feedback) mit ein! Aufgabe des Managements ist es, eine Atmosphäre zu schaffen, in der Fehler nicht kritisch, sondern positiv gesehen werden. Fehler sind Möglichkeiten, um sich selbst und das Produkt zu verbessern!

Als Manager wollen wir eine offene Diskussion, in der Probleme und Unklarheiten oder Befürchtungen offen besprochen werden.

Ist einer der Punkte nicht erfüllt, dann wird keine offene Feedbackatmosphäre vorliegen. Eine konstruktive Diskussion ist kaum möglich.

3 Daten präsentieren

Messwerte bzw. Daten alleine enthalten keine Informationen, die für uns von Nutzen sind. Um aus den Daten sinnvolle Informationen zu gewinnen, müssen diese aufbereitet, interpretiert, vorgestellt und diskutiert werden. Um die wichtigen Informationen aus den Daten zu gewinnen, sind die grafischen und rechnerischen Methoden wichtige Hilfsmittel. Idealerweise werden beide kombiniert. Das Mittel der Wahl ist hier die Statistik!

Warum? Die Statistik ist sehr stark darin, uns mit Hilfe von Grafiken oder Kennzahlen Daten begreiflich zu machen. Es ist auch sehr gut möglich, Aussagen mit einer gewissen Sicherheit treffen zu können. Eindeutige Beweise sind jedoch nicht möglich. Deshalb ist es sinnvoll möglichst breit (also mit möglichst vielen Methoden) auf die Daten zu schauen.

Dazu ein Beispiel:

Um zu überprüfen, ob die Verteilung der Daten einer Normalverteilung entspricht, sollte sowohl ein statistischer Test, als auch ein grafischer Test (z. B. das Wahrscheinlichkeitsnetz) verwendet und gegebenenfalls ein Histogramm erstellt werden. Deuten alle drei Methoden in dieselbe Richtung, dann ist die Aussage deutlich belastbarer.

Für die Vorstellung der Ergebnisse in einem Unternehmen oder vor Fachpublikum gibt es ein paar einfache Tricks für eine erfolgreiche Präsentation.

Ganz grob gliedert sich eine Präsentation in drei Teile, wobei jeder Teil eine der folgenden Fragen beantwortet:

- Was erwartet der Vortragende vom Publikum?

- Warum werden die Ergebnisse vorgestellt?

- Wie wurden die Ergebnisse erreicht?

Die Reihenfolge der Beantwortung der Fragen sollte wie oben beschrieben sein. Im Publikum werden immer Personen sein, die wenig Zeit haben (z. B. Manager). Diese interessiert vor allem, was von ihnen erwartet wird und ob sie eine Entscheidung treffen sollen. Je früher diese abgeholt werden, umso besser. Versuchen Sie nicht wie in einer Erzählung einen Spannungsbogen aufzubauen. Kommen Sie immer direkt zum Punkt und äußern Sie diesen klar.

3.1 Zum ersten Teil: Was erwartet der Vortragende vom Publikum?

Es gibt verschiedene Gründe, warum Ergebnisse vorgestellt werden. Es kann sein, dass ein fachlicher Austausch gesucht wird. Evtl. wird aber auch eine Entscheidung benötigt oder es soll über den aktuellen Stand der Untersuchungen berichtet werden? Diese Frage klärt über das Ziel der Besprechung auf. Es ist wichtig, in kurzen und klaren Sätzen diese Erwartungshaltung klar und eindeutig am Anfang der Präsentation zu formulieren. Dadurch bleibt der Fokus der Besprechung erhalten.

Praxistipp: Was tun um nicht zu tricksen?

Meist ist es ausreichend, ein bis zwei Folien für diesen ersten Teil zu verwenden.

3.2 Zum zweiten Teil: Warum werden die Ergebnisse vorgestellt?

Jede Untersuchung, Besprechung und Analyse kostet Zeit, Geld und / oder Energie. Im beruflichen Umfeld kommt es letztlich darauf an, dass sich diese Ausgabe rechnet, also zu einem Mehrwert führt.

Mit der Frage nach dem Warum wird genau dieser Mehrwert geklärt.

Hier wird der Benefit für das Unternehmen herausgestellt. Es kann sein, dass durch die Untersuchungen das Verständnis für das Produkt oder den Prozess steigt und damit künftig Schaden abgewendet wird. Oder es kann aufgezeigt werden, dass durch die Untersuchungen bei künftigen Produkten Geld eingespart werden kann.

Praxistipp: Was tun um nicht zu tricksen?

Auch für diesen Teil sollen nicht mehr als ein bis zwei Folien genutzt werden.

3.3 Zum dritten Teil: Wie wurden die Ergebnisse erreicht?

Der dritte Teil beinhaltet die eigentlichen Ergebnisse der Untersuchungen. Dieser Teil ist gleichzeitig der umfangreichste.

Bei der inhaltlichen Vorstellung wird mit einer Literaturrecherche oder einer Recherche aus historischen Daten begonnen. Dies ist nötig, um einen breiten Blick zu bekommen und auch von externen Quellen Informationen zu erhalten.

Danach sollten die Ergebnisse kurz und knapp vorgestellt werden. Dabei sollte immer auch auf die Methoden eingegangen werden. Es darf nie davon ausgegangen werden, dass diese Methoden bekannt sind. Je mehr mit grafischen Mitteln gearbeitet wird, umso besser. Wir Menschen tun uns sehr leicht, Bilder oder Grafiken zu interpretieren. Beim Rechnen haben wir jedoch Probleme. Für eine effiziente Vorstellung helfen also Bilder und Grafiken.

Praxistipp: Was tun um nicht zu tricksen?

Am Ende des Vortrags werden das Ziel, der Benefit für das Unternehmen und die Ergebnisse noch einmal kurz zusammengefasst. Auch dafür kann eine Folie ausreichend sein.

4 Fake News selber erstellen, bzw. mit Statistik tricksen

Durch die provokative Formulierung soll in diesem Kapitel die Sensibilität für den richtigen Umgang mit den Daten und der Datenpräsentation geschaffen werden. Nur wenn Sie wissen, wie man mit Statistik tricksen kann (auch unbewusst), können Sie dies vermeiden. Um dies zu verdeutlichen, werden Beispiele auch aus dem Alltag genannt. Die Beispiele sind zum Teil angelehnt an das Buch „Der Hund der Eier legt*“.

4.1 Absolute und relativen Zahlen geschickt verwenden

4.1.1 Absolute Zahlen geschickt nutzen

Besonders beeindrucken kann man durch Verwendung von absoluten Zahlen. Insbesondere dann, wenn diese nicht in Bezug zu anderen Größen gesetzt werden. Vor allem, wenn die Schlussfolgerungen die aus diesen Zahlen gezogen werden, schwerwiegend sind, ist dieser Effekt besonders beeindruckend!

Dazu ein Beispiel aus dem Alltag:

In einem Artikel von 2015 wird dies sehr anschaulich sichtbar. Der Titel lautet: Zahl der Terroropfer steigt weltweit massiv an. Detaillierter wird berichtet, dass weltweit die Zahl der Terroropfer auf 32.658 gestiegen ist.

Die Zahlen sind richtig und „beweisen“ die Aussage. Nun besteht die Frage nach den Schlussfolgerungen. Klar scheint zu sein, das Risiko, Opfer eines Terroranschlages zu werden ist ebenfalls dramatisch gestiegen! Wenn der Terror zunimmt – sogar in den Industrieländern – dann sinkt die Sicherheit und evtl. werden Urlaubsziele oder Großveranstaltungen gemieden. Dadurch sinkt natürlich die persönliche Lebensqualität und das Sicherheitsgefühl.

Durch ein paar weitere Zahlen lässt sich das Ganze in ein anderes Licht rücken. Jährlich sterben weltweit etwa 1,25 Mio. Menschen im Straßenverkehr. Es ist also etwa 40mal riskanter durch einen Verkehrsunfall zu verunglücken, als durch einen Terrorakt. In den Industrieländern (OECD-Ländern) gab es 77 Terroropfer und etwa 125 000 Unfalltote. Hier ist das Risiko also 1500 mal höher im Straßenverkehr zu verunglücken.

4.1.2 Natürlich geht das auch anders herum, und man kann toll mit relativen Zahlen tricksen.

In seinem Blog zeigt Hr. Prof. Gigerenzer ein schönes Beispiel, wie man mit prozentualen Werten tricksen kann. Das Beispiel ist der Wasserstand des Gardasees.

Kurz gesagt war die Aussage in den Medien etwa folgende: „Beliebtes Urlaubsziel fällt trocken: Gardasee nur noch zu 38 Prozent gefüllt“ (Stern). Allerdings ist der Gardasee gar nicht so leer gewesen.

Prof. Gigerenzer zeigt schön auf, dass diese Aussage anders interpretiert werden muss. Die Absenkung des Wasserstands um 38% wird an einem Pegel in Peschiera gemessen. Dieser Pegel hat einen Nullpunkt und misst die Wasserstandshöhe des Gardasees ausgehend von diesem Pegel-Nullpunkt. Der Pegel-Nullpunkt ist jedoch willkürlich gewählt und hat nichts mit der absoluten Seetiefe von ca. 346 m oder der durchschnittlichen Tiefe von 135 m zu tun.

Was ist jetzt geschehen? Der Wasserstand hat sich (gemessen an dem Pegelwert) von 99 cm im März 22 auf 46 cm im März 23 reduziert. Das bedeutet aber dass der Gardasee zwar 53 cm an Wassertiefe verloren hat. Bei einer mittleren Tiefe von 135 m sind das aber keine 35 % sondern sehr viel weniger.

Hinzu kommt, dass der Gardasee als Speicher dient. Sinkt der Pegel deutlich, dann wird Wasser nicht weiter abgelassen. Und im Mai 23 lag der Pegel wieder mit steigender Tendenz bei 80 cm!

Sie sehen, es kommt vor allem auf die Kreativität an.

Praxistipp: Was tun um nicht zu tricksen?

Bei der Präsentation der Ergebnisse sollten immer möglichst alle Daten vorgestellt und vor allem diskutiert werden.

4.2 Nullpunkt bei Achsen unterdrücken

Ein Klassiker ist die Nullpunktunterdrückung. Das bedeutet, dass in Diagrammen sehr stark gezoomt wird. Diese Variante ist besonders gemein, da hier ein visueller Eindruck angesprochen wird, auf den wir besonders intensiv reagieren.

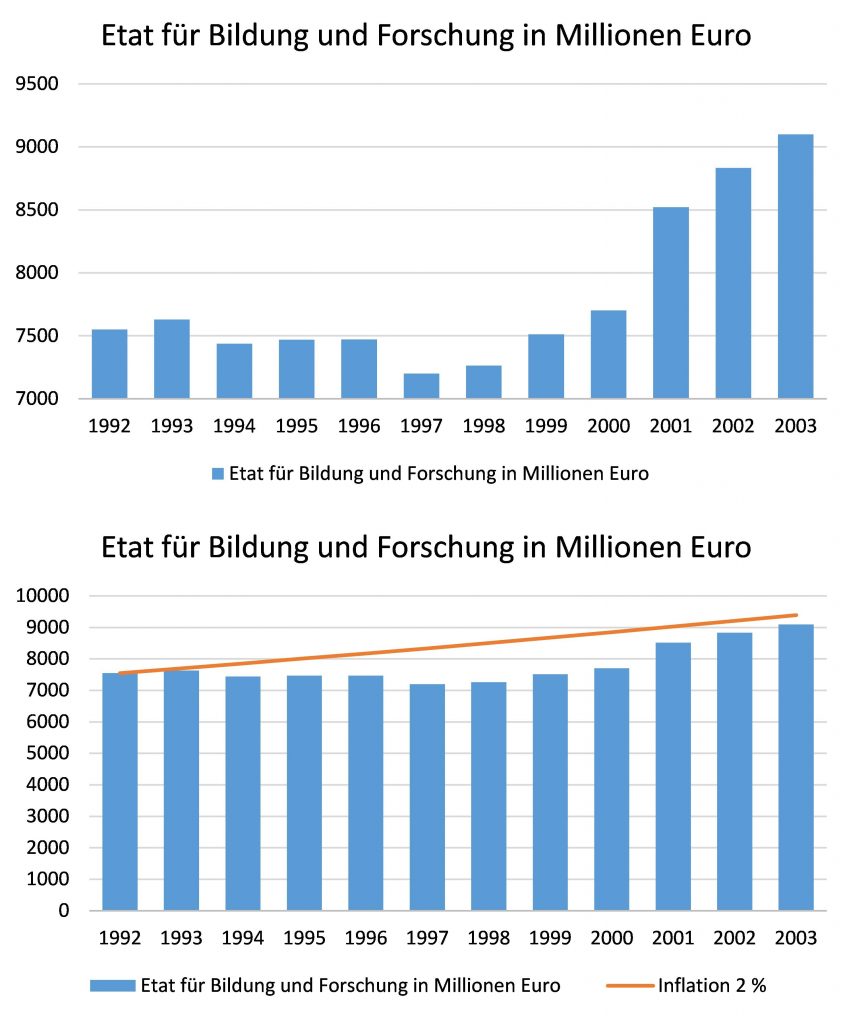

Aus dem Bericht „Antworten zur agenda 2010“ der Bundesregierung von 2003 stammt das folgende Beispiel. Hier wurde behauptet, dass die Ausgaben für Bildung und Forschung dramatisch gestiegen sind. Belegt wird dies durch eine Grafik wie in folgender Abbildung im oberen Bild. Darin zeigt sich ein deutlicher Anstieg der Ausgaben von 1992 bis 2003.

Etat für Bildung und Forschung als Beispiel, wie man geschickt mit Statistiken trickst

Auffallend in dieser Grafik sind zwei Dinge. Zum einen beginnt die y-Achse bei 7000 Millionen Euro. Der Nullpunkt wird unterdrückt. Dadurch wirkt der Anstieg deutlich größer! Zum anderen werden die Zahlen in Millionen Euro und nicht in Milliarden Euro angegeben. Dadurch wirken die Zahlen größer. Gefühlt sind 7000 Millionen mehr als 7 Milliarden.

Im unteren Bild werden zwei Dinge getan. Es wird der Nullpunkt nicht mehr unterdrückt. Dadurch wirkt der Anstieg der Ausgaben für Bildung und Forschung schon deutlich weniger imposant. Zusätzlich wurde noch eine Inflation von 2 % angenommen. Ausgehend von den Ausgaben von 1992 wird geschätzt, wie hoch inflationsbereinigten Ausgaben 2003 sein müssten. Damit lässt sich eine Aussage treffen, wie hoch die Ausgaben für Bildung und Forschung 2003 liegen müssten, um dem gleichen Wert zu entsprechen. Jetzt zeigt sich, das die Ausgaben real (also inflationsbereinigt) gar nicht zugenommen haben!

Wir halten fest, dass die Verwendung großer Zahlen, die Unterdrückung des Nullpunktes und die Vernachlässigung einer Referenz (in diesem Fall die Inflation) mächtige Werkzeuge sind, um mit Daten zu tricksen.

Allerdings muss man auch sagen, dass es durchaus sinnvoll sein kann, einen Nullpunkt zu unterdrücken. Das gilt immer dann, wenn bewusst kleine Änderungen dargestellt werden sollen, die ansonsten nicht sichtbar wären. Ein Beispiel dafür ist häufig in der Messtechnik, wenn Temperaturen gemessen werden. So ist es in Feinmessräumen wichtig, die Temperatur konstant bei ~23°C zu halten. Bereits wenige Grad Abweichung verfälschen das Messergebnis. Hier kann es Sinn machen, den Nullpunkt der y-Achse bei 23°C festzulegen.

Vorsicht gilt außerdem bei logarithmischen Darstellungen! Wir Menschen denken eigentlich fast immer nur linear. Nichtlineare Effekte gibt es allerdings recht häufig. Diese „linearisieren“ wir uns in der Technik häufig durch logarithmieren. In diesem Fall entsteht visuell der Eindruck, dass der Zusammenhang zwischen zwei Größen linear ist, obwohl er in der Realität ein stark nichtlineares Verhalten aufweist.

Praxistipp: Was tun um nicht zu tricksen?

Insbesondere bei Grafiken sollte immer begründet werden, warum genau diese Art der Darstellung gewählt wird. Es sollte auch immer eine umfangreiche Diskussion über die Interpretation der Daten geführt werden.

4.3 Daten weglasssen

Das Weglassen der Daten ist auch eine sehr wirkungsvolle Maßnahme zur Manipulation. Clever macht man dies, in dem die Stichprobe gezielt gewählt wird. Angenommen, Sie planen einen Kinderspielplatz zu bauen und starten eine Umfrage um festzustellen, wie die Anwohner dazu stehen. Wenn Sie nun vorwiegend Familien mit Kindern im relevanten Alter befragen, werden Sie sicherlich günstigere Ergebnisse erhalten, als wenn Sie Anwohner ohne Kinder befragen. Diese für Sie praktische Stichprobe können Sie jetzt statistisch formal richtig auswerten und erhalten das für Sie wichtige Ergebnis.

Nun ist diese Form natürlich sehr manipulativ. Es geht aber auch subtiler. Angenommen, Sie wollen nachweisen, dass sich die Menschen mehr bewegen, draußen an der frischen Luft sind und immer mehr Sport betreiben. Dazu befragen sie 1000 Personen (also eine Menge!). Idealerweise fragen Sie dann mittags bei schönem Wetter 1000 Personen im Park. Sie erhalten dann sicherlich ein deutlich günstigeres Bild, als wenn Sie donnerstags abends um 21 Uhr telefonisch eine Umfrage durchführen.

Im technischen Bereich kann man leicht solchen Irrtümern erliegen. Es soll beispielsweise untersucht werden, ob es zwischen zwei Zulieferern einen Qualitätsunterschied gibt. Bei der Erhebung der Stichprobe ist dann unbedingt auf gleiche Bedingungen zu achten. Da die Qualität abhängig vom Wochentag, Produktionsstandort, der Rohstoffqualität, … schwanken kann, müssen all diese Einflüsse in der Stichprobe berücksichtigt werden. Ansonsten wird das Ergebnis verfälscht sein.

Praxistipp: Was tun um nicht zu tricksen?

Der Planung der Stichprobe sollte größtmögliche Aufmerksamkeit gewidmet werden, denn die Stichprobe bildet die Basis der gesamten Untersuchung.

4.4 Stichprobenanzahl sehr klein wählen

Je kleiner die Stichprobe ist, umso wahrscheinlicher ist es, dass hier rein zufällig ein für Sie günstiges Ergebnis vorliegt. In diesem Fall müssen sie es unbedingt vermeiden Streuungen oder Vertrauensbereiche anzugeben.

Wenn die Stichprobenanzahl klein ist, dann können Sie auch viele Variablen testen. Irgendwann wird dann sicherlich ein statistisch signifikantes Ergebnis auftauchen. Denn in der Statistik nutzt man immer so genannte Signifikanzniveaus. Typisch ist ein Signifikanzniveau von 5% für einen statistischen Test. Das bedeutet, dass mit 95% iger Wahrscheinlichkeit davon ausgegangen werden kann, dass das Ergebnis nicht durch den Zufall erklärt werden kann. Umgekehrt bedeutet dies, dass bei 100 Versuchen/Studien etwa 5 Studien ein falsches Ergebnis liefern, das rein zufällig ist. In einem von zwanzig Fällen ergibt sich also ein zufällig für uns günstiges Ergebnis. Selbstverständlich arbeiten Sie dann nur mit diesem Ergebnis.

Praxistipp: Was tun um nicht zu tricksen?

In der technischen Praxis passiert diese Form der „Manipulation“ eher unbewusst. Hier werden statistische Tests durchgeführt und im Falle einer Signifikanz nicht kritisch hinterfragt. Hier hilft häufig ein nochmaliges Testen (Verifizieren) der Aussagen an einem unabhängigen Datensatz.

4.5 Nur einen Teil der Wahrheit sagen

Sport ist Mord. Wer Sport treibt, geht das Risiko ein sich zu verletzen. Die Kosten für die Behandlung werden dann von den Sozialkassen getragen. Durch Sport entstanden im Jahr 2000 Kosten für den Sozialstaat von ca. 1 650 Mio. €. Diese enormen Kosten sollen (das wäre ja nur gerecht) von den Sportlern getragen werden.

Nun ist diese Aussage aber nur ein Teil der Wahrheit. Es fehlt zum einen die Referenz und zum anderen die Aussage, wie teuer es ist keinen Sport zu treiben.

Mit der Referenz ist die Beantwortung der Frage gemeint, ob es sich wirklich um enorme Kosten handelt. Bezieht man die Kosten durch Sportverletzungen auf die Gesamtkosten im Gesundheitswesen, dann betragen diese gerade einmal 0,8 %. Damit tragen diese kaum zur Belastung der Sozialkassen bei.

Bleibt die Frage offen, was es kostet, keinen Sport zu treiben. Hier treten ebenfalls enorme Risiken auf. Es steigt das Risiko koronarer Herzerkrankungen, Allergien, Bluthochdruck oder Diabetes. Kostenschätzungen liegen für die Behandlung dieser Krankheiten deutschlandweit bei ca. 60 000 Mio. €. Diese Zahl ist deutlich größer als die Kosten für Sportunfälle.

Praxistipp: Was tun um nicht zu tricksen?

Versuchen Sie möglichst neutral zu bleiben und die Ergebnisse von allen Seiten zu beleuchten

4.6 Falsche Signifikanzniveaus wählen

Auch mit der Wahl des Signifikanzniveaus kann sehr gut getrickst werden. Dafür gibt es mehrere Möglichkeiten:

- Wahl des günstigsten Tests,

- Wahl eines zu großen / zu kleinen Signifikanzniveaus (gerne auch nachträglich),

- Verwendung eines einseitigen, anstelle eines zweiseitigen Signifikanzniveaus.

An einem zentralen Beispiel werden diese Möglichkeiten beschrieben. Eine Anlage befüllt Flaschen mit einer Flüssigkeit. Zur Überprüfung der Anlage wird die abgefüllte Menge anhand von zehn Proben überprüft. Folgende Tabelle zeigt die gemessenen Füllmengen in Millilitern.

| Nr. | Volumen in ml |

| 1 | 492,4 |

| 2 | 495,2 |

| 3 | 498,6 |

| 4 | 498,6 |

| 5 | 495,5 |

| 6 | 508,5 |

| 7 | 496,5 |

| 8 | 497,8 |

| 9 | 498,2 |

| 10 | 500,2 |

4.6.1 Wahl des passenden Tests

Manchmal stehen verschiedene Möglichkeiten bereit, um eine Forschungsfrage zu beantworten. Um beispielsweise zu überprüfen, ob die Daten der abgefüllten Volumina näherungsweise normalverteilt sind, kann man das Wahrscheinlichkeitsnetz verwenden, mit dem Kolmogorow-Smirnow-Test arbeiten oder den Anderson-Darling-Test nutzen. Etwas zynisch formuliert ist das sehr praktisch, denn: alle Methoden werden etwas andere Ergebnisse liefern. Das kann genutzt werden, indem nur das Ergebnis der Methode präsentiert wird, welche das gewünschte Ergebnis liefert.

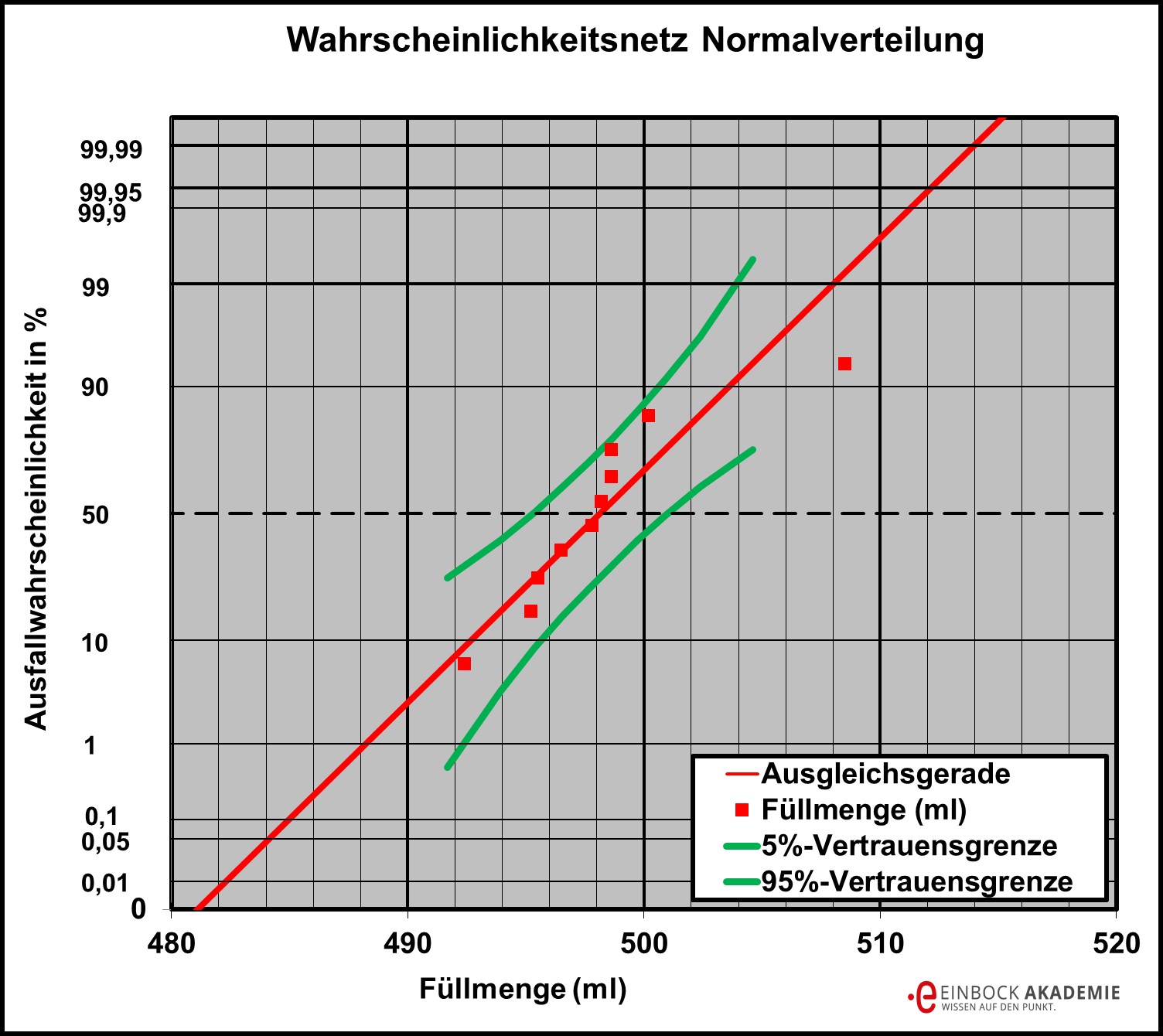

Ziel ist es, zu überprüfen, ob die Füllmengen nach obiger Tabelle normalverteilt sind. Dazu werden alle Verfahren benutzt. Zuerst werden die Daten im Wahrscheinlichkeitsnetz dargestellt, siehe folgende Abbildung. Es scheint für höhere Werte eine Auffälligkeit zu geben, allerdings liegen noch alle Versuchspunkte innerhalb des 90%-Vertrauensbereichs. Es kann somit angenommen werden, dass die Daten näherungsweise normalverteilt sind.

Das Wahrscheinlichkeitsnetz der Normalverteilung am Beispiel von Füllmengen

Alternativ kann auch mit einem statistischen Test die Prüfung auf Normalverteilung erfolgen. Als Signifikanzniveau wird gewählt.

Wird mit dem Kolmogorow-Smirnow-Test gearbeitet, dann ergibt dies, dass die Daten normalverteilt sind.

Alternativ wird mit dem Anderson-Darling-Test geprüft werden. Dieser Test liefert das Ergebnis, dass angenommen werden muss, dass die Daten nicht normalverteilt sind.

Je nachdem, welches Ergebnis gebraucht wird, kann man jetzt also nachträglich den geeigneten Test wählen und präsentieren.

Praxistipp: Was tun um nicht zu tricksen?

Die vermeintlichen Widersprüche müssen in der Statistik akzeptiert werden! Bei Unsicherheiten sollte man immer mit möglichst vielen Tests / Methoden arbeiten, um die Ergebnisse zu interpretieren. Es sollte dann immer nur das Ergebnis genutzt werden, welches das konservativste Ergebnis liefert. Alternativ können beispielsweise auch Stichprobenumfänge erhöht oder Vorwissen genutzt werden.

4.6.2 Die Wahl eines zu großen / zu kleinen Signifikanzniveaus (gerne auch nachträglich)

Üblicherweise wird eine Signifikanz von gewählt. Diese muss vor! dem statistischen Test auf Basis der Überlegungen zur Fehlerschwere festgelegt werden. Tut man dies nicht, bietet sich ein großes Feld der Manipulation.

Am Beispiel der Füllhöhen soll dies gezeigt werden. Um die Normalverteilung zu überprüfen, wurde u. a. mit dem Anderson Darling-Test gearbeitet. Als Signifikanzniveau wurde gewählt. Das Ergebnis war, dass angenommen werden muss, die Daten sind nicht normalverteilt. Es wird nun ein Signifikanzniveau von gewählt. Jetzt kippt das Prüfergebnis. Es kann angenommen werden, dass die Daten normalverteilt sind.

Wie praktisch! Die Argumentation könnte nun wie folgt lauten: Mit 99 %-iger Wahrscheinlichkeit (1 % Fehlerwahrscheinlichkeit) wurde bewiesen, dass die Daten normalverteilt sind. Wer würde da schon widersprechen?

Praxistipp: Was tun um nicht zu tricksen?

Die Nullhypothese lautet, die Daten sind normalverteilt. Sie wird aufgestellt, um verworfen zu werden. Es soll also überprüft werden, ob nicht doch eine andere Verteilung möglich wäre.

Bei einer derart hohen Signifikanz von wird auch bei deutlichen Abweichungen noch angenommen, dass eine Normalverteilung möglich sein kann. Dies führt dazu, dass praktisch nicht erkannt wird, wenn die Daten doch nicht normalverteilt sind (Fehler zweiter Art)!

Ein Beweis für eine Normalverteilung liefert die hohe Signifikanz somit nicht. Wie generell die Statistik keine Beweise liefert. Dieser Fehler zweiter Art wird in der Untersuchung allerdings gar nicht genannt, also verschwiegen. Es muss somit immer vor! der Untersuchung das geeignete Signifikanzniveau festgelegt werden.

4.6.3 Verwendung eines einseitigen, anstelle eines zweiseitigen Signifikanzniveaus

Bei den statistischen Tests werden zweiseitige und einseitige Fragestellungen unterschieden. Soll beispielsweise mit dem t-Test untersucht werden, ob ein Mittelwert signifikant von einem Erwartungswert nach oben oder unten abweicht, spricht man von einer zweiseitigen Fragestellung. Die Signifikanzschranken für den zweiseitigen Test sind dabei größer als die für den einseitigen Test, bei gleicher Signifikanz.

Wenn man vor dem Test nicht weiß, ob der Mittelwert ober- oder unterhalb des Erwartungswertes liegen wird, muss mit der zweiseitigen Fragestellung gearbeitet werden. Dies bietet Chancen für Manipulationen. So könnte man erst bewerten, ob der Mittelwert größer oder kleiner als der Erwartungswert ist und dann mit der einseitigen Fragestellung arbeiten.

Praxistipp: Was tun um nicht zu tricksen?

Vor dem Ergebnis muss entschieden werden, ob es sich um einen einseitigen oder zweiseitigen Test handelt.

5 Auf den Punkt

Die Statistik ist ein Wertvolles Werkzeug, um Versuche zu planen, auszuwerten und zu interpretieren. Dabei sind allerdings ein paar wichtige Prinzipien zu beachten.

Die richtige Einstellung:

- Suchen Sie aktiv nach Feedback.

- Als Manager versuchen Sie eine positive Feedbackkultur zu gestalten.

Daten präsentieren: Ganz grob gliedert sich eine Präsentation in drei Teile, wobei jeder Teil eine der folgenden Fragen beantwortet:

- Was erwartet der Vortragende vom Publikum?

- Warum werden die Ergebnisse vorgestellt?

- Wie wurden die Ergebnisse erreicht?

Mit Statistik tricksen:

- Bei statistischen Analysen ist immer Vorsicht geboten. Dies gilt insbesondere bei Daten, die Sie nicht selber erhoben haben.

- Nicht nur die Stichprobengröße, sondern vor allem die Zusammensetzung ist wichtig.

- Planen Sie Versuche und deren Auswertung immer sorgfältig.

- Diskutieren Sie Ihre Ergebnisse offen mit Kollegen, um mögliche Fehler schnell aufzudecken und dann schnell beheben zu können.

- Das Signifikanzniveau muss vor einem statistischen Test unter Berücksichtigung der Auswirkung der Fehler erster und zweiter Art festgelegt werden.

- Wenn mehrere Tests möglich sind, sollte immer das kritischste Ergebnis genutzt werden.

- Vor der Untersuchung muss geklärt sein, ob es sich um eine einseitige oder zweiseitige Fragestellung handelt.

- Widersprüche in statistischen Aussagen sollten zugelassen und intensiv diskutiert werden.

Das wichtigste Prinzip ist vielleicht, dass sich die Aussagen und Auswertungen immer mit dem eigenen Gewissen decken müssen.

Weiterführende Informationen zur Auswertung von Wöhlerversuchen

Hier finden Sie ähnliche Artikel und Informationen zu passenden Seminaren und Büchern. Außerdem können Sie den Inhalt des Artikels bewerten.

Bewerte den Artikel!

[yasr_visitor_votes size="medium"]

Seminar DoE: Design of Experiments - ein schneller Einstieg in die Anwendung

Das Seminar DoE: Design of Experiments

liefert Ihnen einen schnellen Start in die statistische Versuchsplanung. Damit können Sie Ihre Versuche sicher planen, begleiten und auswerten. Sie lernen, wie Sie mit minimalem Aufwand (Stichproben) die Einstellgrößen für die Inputfaktoren erhalten um optimale Größen für die Outputparameter zu erzielen. Gleichzeitig zeigen wir Ihnen die wichtigsten Grundlagen der Statistik für einen schnellen Einstieg. Und als besonderen Bonus erhält jeder Teilnehmer eine Schulungslizenz von Minitab®.

Der Schwerpunkt des Seminars liegt auf folgenden Themen:

- Einführung in die Statistik Software Minitab® inkl. Schulungslizenz!

- Grundlagen der Statistik, Korrelation/Regression und Hypothesentests,

- Nicht-systematische und systematische Versuchspläne,

- Analysen von Haupteffekten und Wechselwirkungen,

- Nicht-lineare Versuchspläne: Wirkungsflächenpläne (Response Surface Designs),

- Tipps und Tricks für eine schnelle Anwendung im Alltag,

- Praktische Beispiele mit vollständigen praxisnahen Datensätzen zum Mitnehmen,

- Voraussetzungen für korrekte Analysen der Ergebnisse.

Ein großer Schwerpunkt liegt auf der praktischen Anwendung der Methoden in der Software Minitab®. Gerne auch mit Ihren eigenen Datensätzen! Hierfür erhalten Sie eine Schulungslizenz mit dreimonatiger Gültigkeit.

Seminar Technische Zuverlässigkeit - Bauteile robust auslegen und effizient erproben

Lernen Sie in dem

Seminar zur technischen Zuverlässigkeit

mittels qualitativer und quantitativer Methoden der Zuverlässigkeitsgestaltung und -validierung wie Sie Bauteile robust auslegen, um Ausfälle Ihrer Produkte zu vermeiden und wie Sie Bauteile effizient erproben um Risiken zu vermeiden und gleichzeitig Kosten bei der Erprobung zu sparen.

Sie lernen die

- Grundlagen der typischen Lebensdauerverteilungen wie, der Normalverteilung, Weibullverteilung, Exponentialverteilung sowie das Wahrscheinlichkeitsnetz den Vertrauensbereich kennen

- Versuche selbständig planen, auswerten und interpretieren

- Wahrscheinlichkeitsnetze inkl. Vertrauensbereiche erstellen und beurteilen

- das Festlegen des erforderlichen Stichprobenumfangs mittels Larson Nomogramm

- wichtige Lebensdauermodelle kennen: Arrhenius, Wöhlerlinien, Coffin-Manson, Norris-Landzberg.

- Regressionsmethoden anwenden und erfahren, wie Sie Versuchsergebnisse auf beliebige Ausfallwahrscheinlichkeiten umrechnen können

- die typischen Klassierungsmethoden Rainflow-Zählung und Momentanwertmethode anwenden

- wie unter Betrachtung bestimmungsgemäßer Gebrauch, Worst Case und Misuse Lastkollektive erstellt werden

- die lineare Schadensakkumulation als Methode zur Berechnung der Bauteillebensdauer anwenden

- Succes Run Erprobungen zu planen und auszuwerten

- wie Versuchszeiten gerafft werden können.

Außerdem werden

- alle Themen werden softwareneutral vorgestellt

- die Seminarinhalte durch ein umfangreiches Komplexbeispiel zusammengefasst.

Ziel dieses Seminars ist es, dass Sie danach Ihre Bauteile robust auslegen und effizient erproben können.

Seminar Werkstoffkennwerte der Betriebsfestigkeit (für Simulation und Auslegung) einfach ermitteln und anwenden

Wollen Sie Ihre Versuche so kostengünstig wie möglich und mit der geringsten Anzahl an Versuchen durchführen? Dann ist evtl. unsere Wöhlerlinien auswerten und Versuche planen für Sie richtig.

Sie lernen hier,

- wie Sie Wöhlerversuche und Dauerfestigkeitsversuche mit geringst möglichem Stichprobenumfang durchführen

- Wöhlerlinien und Dauerfestigkeiten statistisch auszuwerten

- Ausreißer zu finden und mit Ausreißern umzugehen

- Versuche aus der Vergangenheit zu nutzen

- mit sehr geringen Stichprobenumfängen umzugehen

- Sicherheiten für Ihre Bauteilauslegung abzuleiten

- zwei Wöhlerlinien statistisch miteinander zu vergleichen

- einen kurzen Einstieg in die Betriebsfestigkeit kennen.

Weiterführende Literatur

Statistik der Betriebsfestigkeit - schnell verstehen & anwenden

Um Wöhlerkurven und Dauerfestigkeiten statistisch auszuwerten und zu planen, bietet sich außerdem unser Buch Statistik der Betriebsfestigkeit an.

dieses führt Sie schnell und verständlich in die Versuche und die Statistik Betriebsfestigkeit ein und liefert gleichzeitig noch viele Excel Tools zur einfacheren Auswertung von Versuchen der Betriebsfestigkeit wie Wöhlerlinien.

Technische Zuverlässigkeit mit Minitab (R)

Produkte werden komplexer und Kundenansprüche bzgl. Nutzungsdauer, Qualität, Sicherheitserwartung und Kosten steigen. Man löst dieses Spannungsverhältnis verstärkt durch eine höhere Auslastung der Bauteile und effizientere Erprobungsmethoden. Hier helfen die Methoden der technischen Zuverlässigkeit, denn bei Kenntnis der Lasten, und der Werkstoffgrenzen können Bauteile höher ausgelastet und Erprobungskosten gespart werden.

Unser Buch

TECHNISCHE ZUVERLÄSSIGKEIT mit MINITAB® – Bauteile robust auslegen und effizient erproben

begleitet das Seminar und hilft Ihnen bei einem Einstieg oder der Vertiefung bei der Ableitung/Interpretation effizienter Erprobungen und dem Nachweis der Zuverlässigkeit Ihrer Produkte:

- Alle Rechnungen Schritt für Schritt erklärt

- LV124 oder VDA Band 3 Teil 2 verstehen

- Grundlagen der Zuverlässigkeitstechnik

- Lastkollektive auswerten und ableiten

- FMEA verstehen und anwenden

- Zuverlässigkeiten berechnen

- Erprobungen planen/auswerten

- Success Run Tests planen

STATISTIK für Ingenieure und Naturwissenschaftler (mit Excel)

Dieses Buch bietet Ihnen einen schnellen und verständlichen Einstieg in die Statistik für Ingenieure und Techniker. Sie sind damit in der Lage Versuche und Daten selbständig zu planen, auszuwerten, zu interpretieren und zu präsentieren. Es werden die wichtigsten statistischen Tests vorgestellt, zahlreiche Beispiele und Praxistipps von Ingenieuren für Ingenieure gegeben, die Ihnen in Ihrem Alltag Lösungen für statistische Probleme bieten.

STATISTIK für Ingenieure und Naturwissenschaftler (mit Excel) - endlich verständlich

Der Inhalt:

- Grundlagen: Grafiken und Merkmale

- Grundlagen: Verteilungen und Vertrauensbereiche

- Stichproben erheben

- Messystemanalysen durchführen

- Regression und Korrelation

- Einführung in statistische Tests

- Tests auf Mittelwertunterschiede

- Tests auf Streuungen

- Tests auf Verteilungen

- Ausreisser bewerten

- Poweranalysen und Stichprobenumfänge festlegen

- Mit Statistik tricksen